Les écosystèmes logiciels pour la création temps-réel

// Conception interactive // Les écosystèmes logiciels pour la création temps-réel

Les développements technologiques sont souvent présentés comme des produits de consommation, où leurs concepteurs privilégient la commercialisation au détriment de l’expérience et du bien-être de l’utilisateur. On nous vend des solutions pour automatiser des tâches et répondre à un désir (ou une pression) de productivité. Cependant, cette promesse ne tient pas toujours compte de l’interopérabilité des gadgets que nous accumulons déjà. En tant que consommateurs, nous nous retrouvons souvent étourdis par une offre en constante évolution, reposant sur l’idée préconçue que « nouveau » rime avec « meilleur ». Ainsi, l’interface numérique filtre nos activités quotidiennes : à son meilleur, elle devient imperceptible, mais sinon, elle se transforme en une distraction frustrante : « La technologie, ça ne marche jamais ! »

Cette tendance s’applique également aux outils de création numérique, qui offrent désormais une multitude de jouets aux interfaces graphiques simplifiées et colorées. Cette approche gagne en popularité, notamment avec les plugins spécialisés et les outils de génération de contenu par intelligence artificielle. Toutefois, cela cache un manque de transparence concernant le fonctionnement et la portée de ces outils. La création de contenu est à la portée de tous, du moins que l’on se laisse guider par le médium et ses esthétiques dans sa forme actuelle.

Pourtant, l’artiste a le potentiel de naviguer à travers ces contraintes et de détourner l’utilisation de ces outils. L’une des grandes forces du numérique réside dans la capacité de modifier les outils à notre disposition, permettant ainsi d’ajuster, voire de jouer avec la présence de ce filtre.

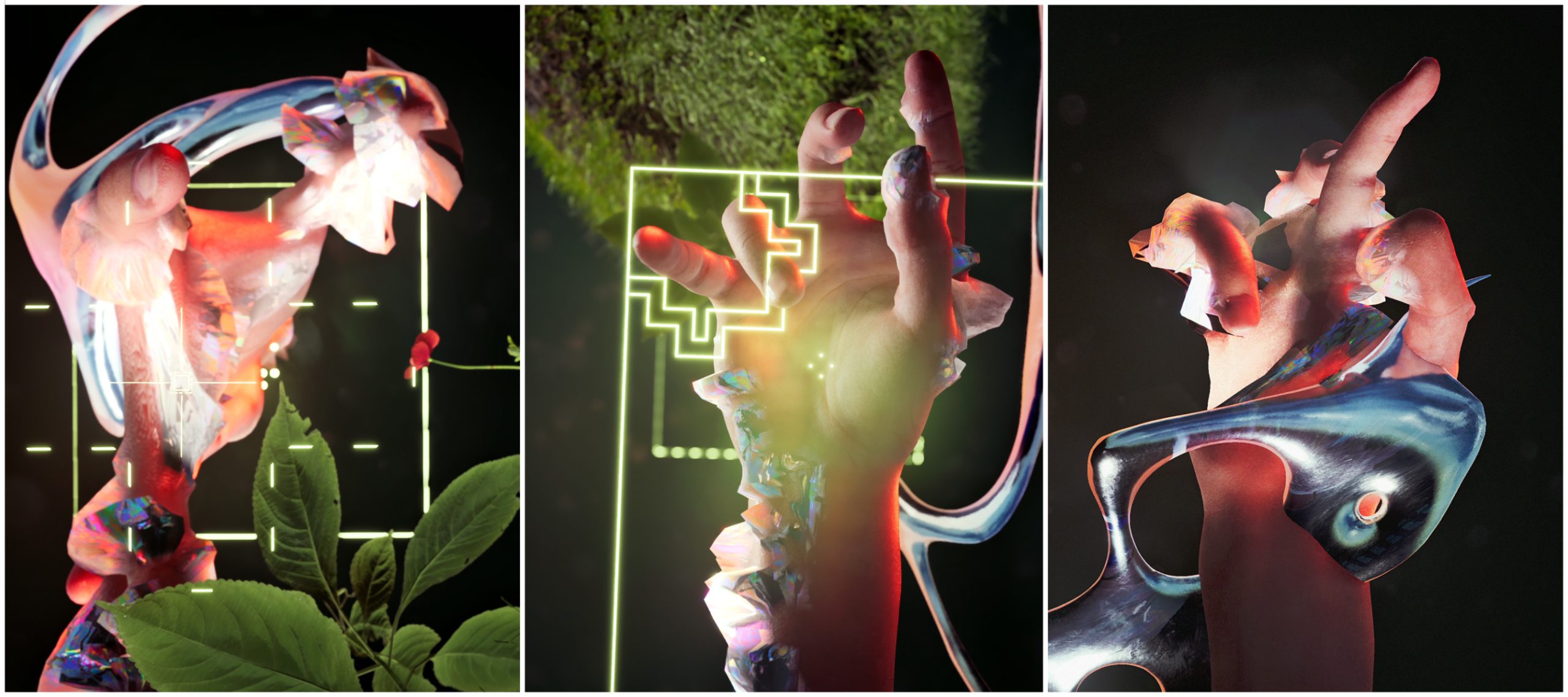

Ces réflexions sont partagées ici pour vous inviter à repenser l’ergonomie de nos relations avec les technologies, en mettant en lumière des aspects souvent négligés de l’interaction humain-machine. Nous aborderons notamment le logiciel Unreal Engine et son application dans le cadre d’une résidence de création dans la Satosphère, un espace immersif unique de la Société des Arts Technologiques (SAT).

La Satosphère

Performance dans la satosphère à la Société des Arts Technologiques, crédit photo: Gabrielle Tetrault, 2024.07.18

La Société des arts technologiques (SAT) à Montréal abrite la Satosphère, un théâtre immersif en forme de dôme. Mesurant 18 mètres de diamètre et 11.5 mètres de hauteur, elle est équipée de 8 projecteurs et de 98 canaux audio, offrant une expérience immersive à 360 degrés horizontalement et 210 degrés verticalement. Toutefois, la complexité technique de ce médium peut détourner les artistes de leur processus créatif. Chaque idée doit être traduite et transformée via une chaîne de logiciels avant d'être testée, ralentissant ainsi le processus de création et limitant l'accessibilité de ce médium pour les artistes.

La majorité de la création dans le dôme s’effectue donc en dehors de celui-ci. Malheureusement, la complexité technique persiste même à l’extérieur : par exemple, les fichiers d'image sont souvent six fois plus lourds que ceux utilisés dans une création numérique 2D traditionnelle, obligeant les artistes à attendre de longs rendus avant de voir leurs scènes prendre forme. De plus, l'image est déformée, nécessitant l'utilisation de techniques de prévisualisation comme des maquettes ou des simulations via un casque VR, ce qui éloigne encore davantage les créateurs de leur médium. Bien que la création sonore soit légèrement moins contraignante, elle reste soumise à des restrictions similaires. Au lieu de traiter le mixage sonore en stéréo, chaque source sonore doit être spatialement positionnée dans l’espace sur l’ensemble des canaux audio. Il est possible de simuler cette spatialisation avec une interprétation binaurale des 98 canaux, mais cette approche ne reproduit pas fidèlement l’acoustique réelle du dôme.

Enfin, le rapport d’échelle avec le dôme, haut de 11.5 mètres, est difficile à reproduire lorsque l’on travaille sur un ordinateur à échelle humaine. Un casque VR peut simuler cette échelle, mais il introduit une barrière supplémentaire dans l'expérience de création. Ce n’est qu’après avoir conçu, rendu, et intégré le contenu que l’artiste peut le visualiser dans le dôme. Si des modifications sont nécessaires, l’artiste doit alors retourner dans le projet, ajuster à l’aveugle, puis relancer les rendus, ce qui peut prendre plusieurs heures, voire des jours.

Unreal Engine

Unreal Engine est avant tout un moteur de rendu 3D temps-réel servant à créer des jeux vidéos (moteur de jeu). Cependant, il s’agit aussi d’un logiciel de création très polyvalent idéal pour les pratiques interactives, performatives et d’animation. Bien que la licence de ce logiciel ne soit pas entièrement libre (open source), la majorité des utilisateurs auront une licence d’utilisation gratuite et auront accès au code source de l’outil pour se l’approprier. (source available)

Unreal Engine permet de concevoir des environnements virtuels et d’y programmer des interactions entre l’utilisateur, des personnages et l’environnement. Les intéractions permettent de modifier l'état des acteurs présents dans la scène, de déclencher des sons, d’ajuster l’environnement, etc. Il offre aussi des éditeurs de base pour la modélisation, le rigging, etc.

Contrairement à Blender, un logiciel très répandu pour la modélisation et les rendus 3D, Unreal Engine priorise l’expérience et les interactions afin de créer des comportements. Cette approche est rendue possible par l’engin qui calcul en temps-réel tous ces éléments. Ceci-dit, Blender demeure un atout essentiel à la création d’environnement virtuels dans Unreal.

Toutefois, il est à considérer que Unreal Engine requiert une certaine structure pour mettre en place ses idées. Puisque l’outil est avant tout pensé pour une industrie. C’est dans l’espoir de pallier cet obstacle que je partage mon expérience, mes stratégies et quelques ressources.

Réduire les frictions

Je propose donc de réduire ces frictions en rapprochant physiquement les artistes du médium, minimisant ainsi les pertes de temps et la charge mentale, tout en créant un environnement propice à une exploration créative.

La création en temps réel permet d’ajuster l’environnement virtuel sur place, au moment où l’artiste est confronté à sa création dans son rendu final, telle qu’elle sera présentée au public. Cela instaure une sensibilité accrue qui permet de sculpter l’expérience en soi. Ce qui est essentiel avec un médium aussi sensationnel que le dôme. Cette expérience ne peut être recréée ailleurs.

L’artiste et le médium sont connectés dans un processus de création spontané, donnant naissance à des « heureux accidents ». C’est ici que la capture de mouvement et les contrôleurs MIDI interviennent pour traduire les gestes et les réactions de l’artiste en données influençant le logiciel de création.

La précision des gants de capture de mouvement conserve les imperfections des gestes. Combinées à la souplesse d’un système paramétrique, ces imperfections laissent place à une part d’incertitude qui est un élément clé de ces explorations.

Cette création, d’emblée performative, donne lieu à une mise en scène qui déborde de l’environnement numérique vers le monde réel. Par souci de concision, cette tangente, qui mériterait ses propres fiches sur ce site, ne sera pas couverte par cette fiche.

Il est également possible de capter la scène en direct, ce qui élimine plusieurs étapes de gestion de fichiers. Si nécessaire, les captations peuvent ensuite être montées dans un logiciel de montage conventionnel, offrant ainsi une approche hybride qui combine la spontanéité de la performance avec la précision de la post-production.

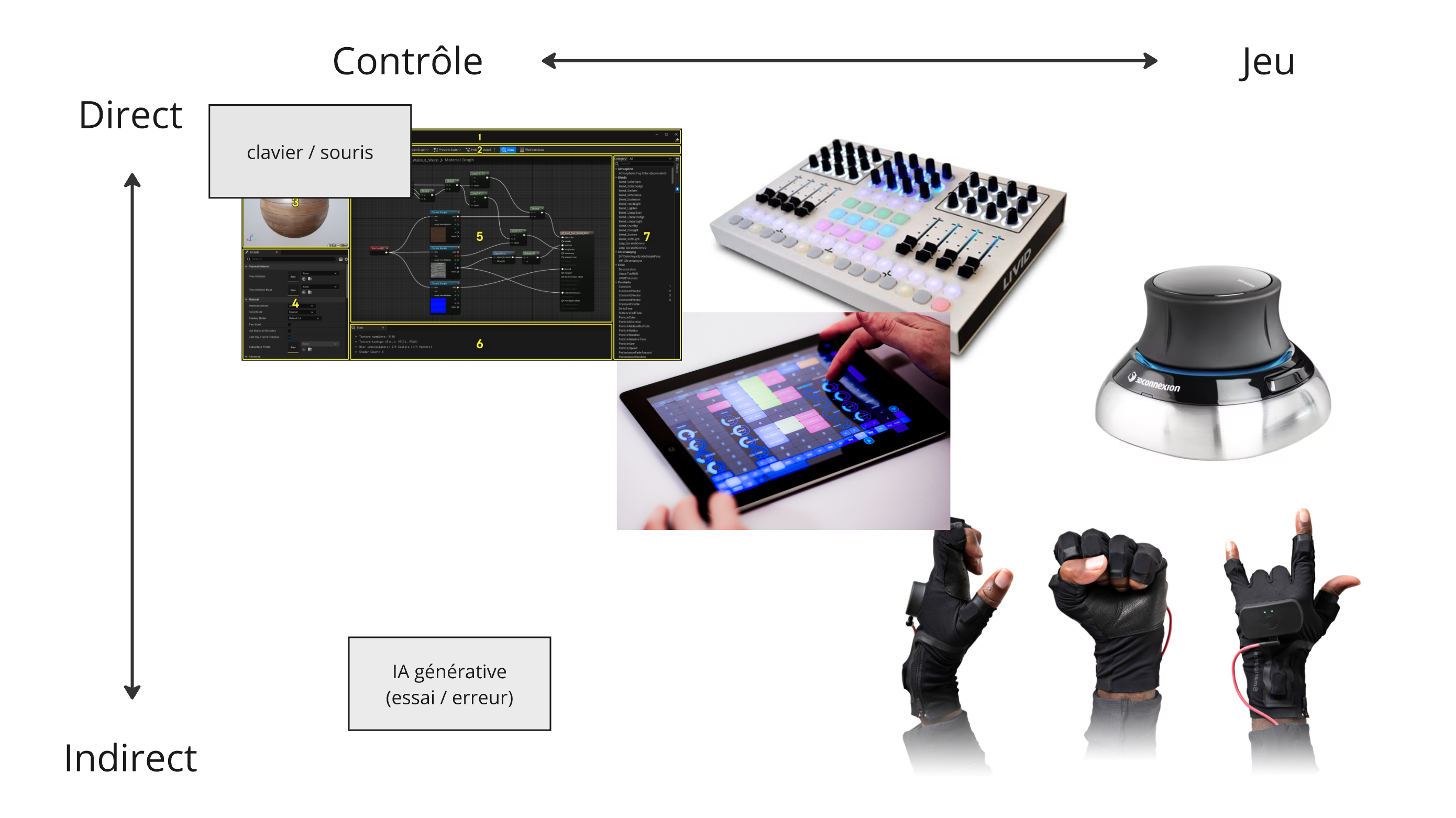

Conception vs. Jeu: une question de contrôle.

L’aspect le plus important dans tout cela est que l’artiste peut réagir spontanément aux sons, aux images ou aux actions d’autres collaborateurs, influençant ainsi directement le contenu et le comportement de l’environnement virtuel. Ces explorations, favorisant l’imprévu, créent une période de jeu.

Bien que riche et stimulant, le jeu en art numérique est néanmoins limité par l’outil avec lequel on interagit. Les phases de développement de cet outil constituent des périodes de conception. Celles-ci me permettent de prototyper des interactions qui doivent ensuite être testées par le jeu. Ainsi, ces deux approches sont interdépendantes. Un jeu avec un outil simple serait trop limité, tandis qu’un outil avec trop de paramètres et peu de raffinement manquerait d’ergonomie. Au quotidien en création, différents degrés de contrôle et de jeu s’avèrent nécessaires à des moments distincts, il n’y a donc pas d’approche strictement meilleure; je propose plutôt de diversifier les approches.

Par exemple, les paramètres d’une interface graphique d’un logiciel permettent un contrôle précis sans exiger trop de programmation préalable, mais l’on se retrouve limité à l’utilisation du clavier et de la souris. Cela réduit les possibilités de jeu et affecte l’ergonomie en création. L’ajout d’un contrôleur MIDI assigné à ces paramètres permet d’explorer plus intuitivement à la recherche d’un sweet spot.

Je constate que les outils offrant un jeu organique et intuitif nécessitent des phases de conception plus longues. À l’inverse, un outil peu abouti montre rapidement ses limites. Les phases de jeu incitent à affiner l’outil, à le remettre en question, puis à l’ajuster en fonction des observations. On alterne ainsi entre ces deux phases pour perfectionner progressivement l’instrument.

Si l'on compare avec l'expérience de création d'une animation linéaire, utilisant une timeline et des keyframes, celle-ci demande moins de préparation en amont, mais n'offre qu'une seule proposition. En revanche, l'élaboration du jeu permet d'explorer la scène sous différents angles, de laisser place à l'imprévu et d'intégrer des collaborateurs dans le processus, créant ainsi une interaction directe avec la création.

Pistes Techniques et Ressources

Voici quelques pistes afin de rapprocher l’engin de jeu Unreal des besoins des artistes en art numérique.

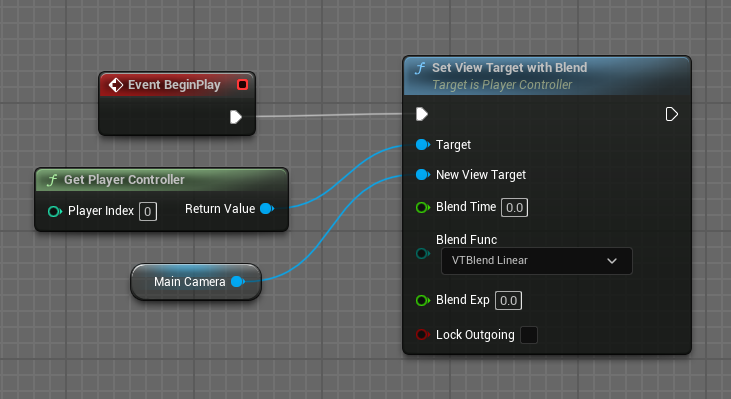

Il est possible de remplacer le personnage (pawn) par une cine caméra qui nous servira de point de vue sur le monde virtuel afin d’obtenir plus de paramètres.

On peut placer cette fonction à peu près n’importe où. Par exemple dans le Level Blueprint (BP) (pas recommandé) ou mieux: Dans un BP dédié à la caméra ou encore dans le BP du Game Mode.

La cine camera permet d'aborder l’environnement virtuel comme un studio de tournage. Elle permet de cadrer avec un regard photographique plutôt que du point de vue d’un personnage de jeu. Selon l’approche créative, on peut animer cette caméra avec une timeline fixe (sequencer), en temps réel avec une manette de jeu, ou une source externe en OSC ou MIDI via un autre logiciel.

Comment créer un serveur OSC: https://www.youtube.com/watch?v=DI2F-1iwOHANote: Ce tutoriel ne couvre pas l’optimisation et la mise en place de fonctions permettant de communiquer entre les acteurs. Il y a plusieurs méthodes pour y arriver. Casting ou Blueprint Interfaces.

Remote Control est une autre méthode de contrôle via OSC qui requiert moins d’implémentation mais qui est plus limitée.

Plusieurs outils de contrôle sont pensés pour les artistes. Voici quelques exemples.

- TouchDesigner

- Ossia Score (open source)

- Chataigne (open source)

- Iannix (open source)

- Open Stage Control (open source, permet de créer des surfaces de contrôle accessible de n’importe quel appareil sur un réseau)

- TouchOSC (app pour iOS et Android)

- Isadora

Il existe plusieurs solutions de capture de mouvement compatibles avec Unreal en temps réel via Live Link. Voici un exemple avec Rokoko

Cette approche nécessite que le data de mouvement soit compatible avec le squelette de notre personnage. Il est possible d’adapter ce data avec une technique de retargetting exemple: https://www.youtube.com/watch?v=iE474cUpR-o, Retargeting

Récupérer le flux vidéo d’Unreal est assez facile grâce à un plugin. Off World Live ajoute des entrées et sorties NDI et Spout. Ainsi, l’engin peut s'intégrer dans un écosystème plus large. Le plugin inclut aussi une caméra 360 parfaite pour les dômes. Pour les projets non-commerciaux, ils offrent une licence gratuite. OWL constitue un des pilliers de mon approche avec Unreal. Youtube, Discord

Finalement, Il est possible de “doubler” la performance du moteur de rendu d’Unreal engine grâce à l’intelligence artificielle avec la technologie Deep Learning Super Sampling (DLSS) par NVIDIA.

Autres ressources Unreal

- PrismaticaDev, 5-Minute Materials, une série de tutoriels sur les shaders dans Unreal

- Matthew Wadstein, WTF Is? - Une série sur les principales fonctions blueprint.

- William Faucher pour des techniques d’éclairage et des trucs sur le scan 3D et leur intégration dans Unreal.

- Blueprint best practices - BPI

- Can you pet the dog, Integration de Physics Control Plugin dans Unreal.

- Alex Coulombe, Trucs utiles

- Jon Jags Nee, implémentation d'un ppv et ajustement pour l'exposition manuelle

Crédits

Lors de la résidence à la SAT en juillet 2024, j'ai été accompagné par:

- Mourad Bennacer, formation spatialisation sonore.

- Jules Roze, tech vidéo dôme et documentation vidéo

- Pablo Geeraert, tech son dôme et design sonore.

- Christophe Godon, tech dôme

- Manuel Bolduc, programmation pour interface entre UE et SpatGRIS

- Simon Giguère, éléments graphiques

- Antoine Doré, design sonore

Merci!