Intégration de capteurs sur un performeur : une étude technique

// Conception interactive // Intégration de capteurs sur un performeur : une étude technique

Dans le cadre du projet Interface humaine, je désire approfondir les questionnements sur la relation entre un danseur augmenté numériquement et les éléments médiatiques et scénographiques qui l’entourent, tant sur le plan technologique que chorégraphique et dramaturgique. Je désire explorer le dialogue entre le performeur et cet univers hyperconnecté, son rapport avec le mouvement, le rythme. Je mène une recherche axée sur la sensibilité, autant du côté artistique et humain que du côté technique, et sur l’exploration d’images, de mouvements et d’états. Comment la technologie peut-elle devenir une extension de la performance et générer une dramaturgie? Comment le performeur arrive-t-il à contrôler l’environnement au niveau de la lumière, du son et du décor afin de créer un univers poétique numérique singulier, innovant et immersif? Comment, grâce au numérique, peut-on créer une symbiose tellement complexe et organique entre performeur et nouveaux médias qu’on en vient à oublier la nature même des technologies utilisées? Je désire que le performeur, fusionné avec les capteurs, interagisse avec une précision telle qu’au bout du compte l’espace et le corps ne font qu’un.

Une première exploration

La première fois que j’ai travaillé avec des capteurs sur une performeuse fut lorsque je travaillais au Laboratoire de muséologie et d’ingénierie de la culture (LAMIC) et au Laboratoire des nouvelles technologies de l’image, du son et de la scène (LANTISS), à l’Université Laval. C’était en 2011, et le projet en question était Echo Sonore, de l’artiste Marjorie De Chantal. Nous utilisions un système de capteurs acquis par le LANTISS dont le nom m’échappe, mais on y trouvait des capteurs de flexions et des capteurs de type Inertial Mesurement Unit (IMU). Installés sur son corps, ces capteurs permettaient à Marjorie d’interagir directement avec la trame sonore par l’entremise des mouvements de son corps.

Interface humaine

C’est en 2017 que j’ai repris cette exploration avec le metteur en scène Émile Beauchemin, moment qui marque la naissance officielle du projet Interface humaine et de mon désir de travailler plus activement à repousser les limites de cette approche en art vivant.

Le matériel

Un des premiers objectifs que j’ai voulu accomplir est d’éliminer le fil entre le performeur et l’ordinateur afin que celui-ci puisse être plus mobile. Le premier prototype utilisait un Raspberry Pi avec le logiciel Pure Data, et il était assez gros et encombrant. Mais bon, c’était un premier prototype!

Rapidement, l’utilisation du Raspberry Pi s’est avérée trop complexe, et il était encombrant. J’ai rapidement changé pour une approche plus simple et moins embarrassante : l’utilisation des microcontrôleurs ESP32 (et c’est encore ceux que j’utilise aujourd’hui). Ces microcontrôleurs servent simplement de pont sans fils (via WiFi) entre les capteurs et l’ordinateur, en transformant les données dans les capteurs au protocole OSC.

Durant ces premières étapes de résidences, nous avons testé une multitude de capteurs :

- Tension musculaire

- Électrocardiogramme (ondes du cœur)

- Ondes cérébrales

- Rotation (IMU)

- Flexibilité

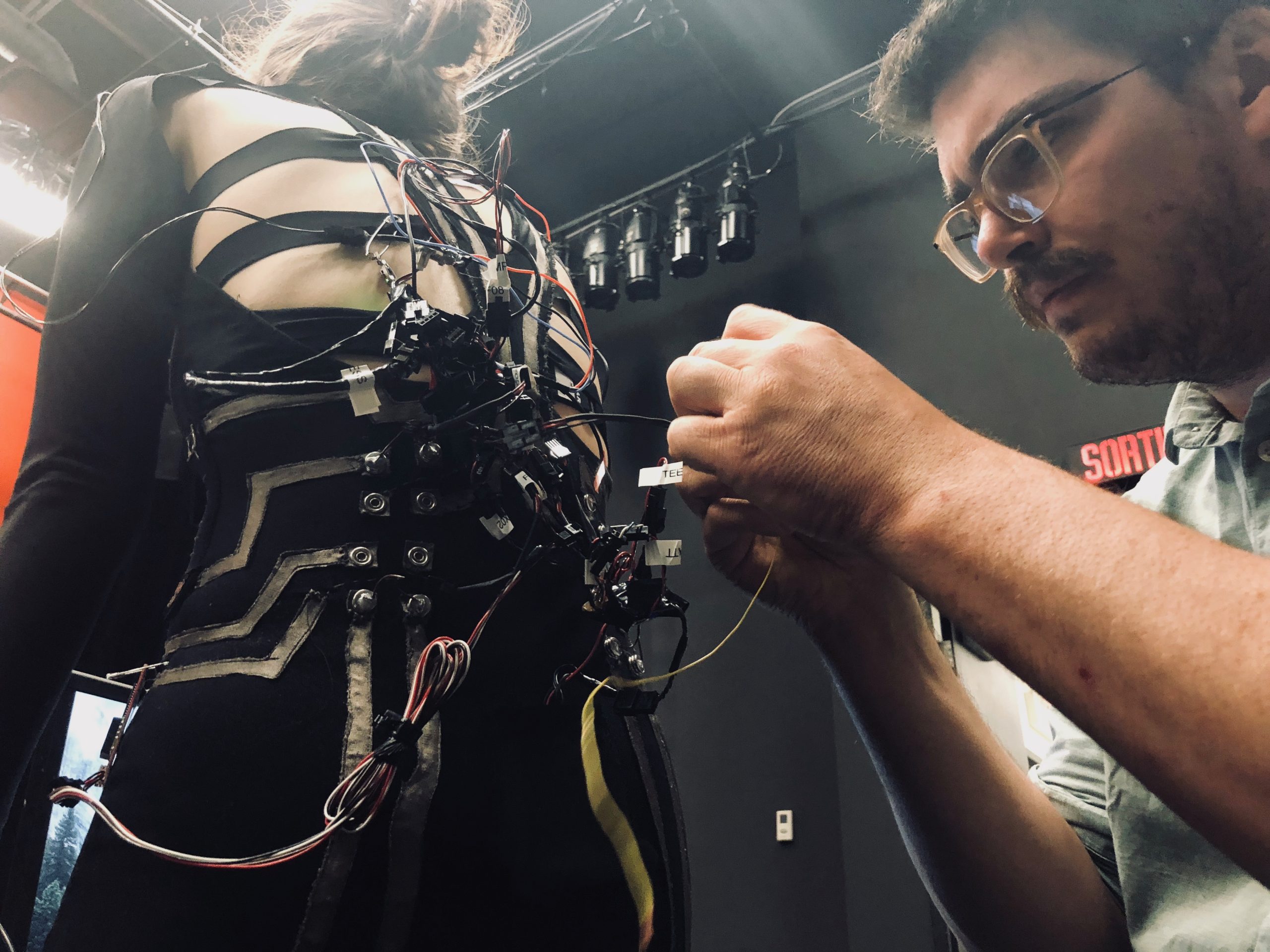

Quand tous ces capteurs étaient sur un même costume, ça faisait pas mal de fils. Nous avons donc exploré l’utilisation de tissus conductifs afin d’intégrer les connexions des capteurs à même le costume. Comme vous pouvez le voir, cette première version du costume était assez bordélique, et pour être bien franc, pas super fiable. Il était vraiment facile pour le performeur d’accrocher un fil et de le déconnecter…

Les logiciels

Afin d’assigner les données de tous ces capteurs, j’ai commencé à développer une interface à l’aise du logiciel Max/MSP, permettant de choisir quels capteurs sont assignés à quels médias (son, vidéo, éclairage, robotique), et comment.

Un dernier élément que j’aimerais ajouter, sur cette première phase de recherche, est l’exploration du machine learning (apprentissage automatique) via le logiciel Wekinator (qui n’est malheureusement plus développé). Avec celui-ci, nous pouvions assigner la valeur de tous les capteurs à un moment donné à des paramètres simples tels que le volume d’un son, l’opacité d’une image, la valeur du cue de lumière, ce qui permettait de rendre toute cette complexité beaucoup plus naturelle. Nous pouvions donc ainsi « enregistrer » des positions du performeur et les transformer en outil d’interaction complexe et fluide avec l’environnement.

JIQ

En 2017, j’ai été invité à créer un court spectacle pour la JIQ, un évènement d’affaires et de technologies de l’information qui avait lieu à Expocité. Pour ce projet, j’ai acquis des capteurs de type IMU très performants, qui sont encore disponibles aujourd’hui : https://x-io.co.uk/. J’en ai installé un sur chaque poignet du danseur Chad E Conception, ainsi qu’un sur sa tête, pour ensuite associer les mouvements de son corps aux mouvements de la vidéo projetée derrière lui.

Corps percussif augmenté

C’est en 2021 que j’ai entamé une deuxième phase de recherche sur ce projet, avec l’artiste en danse Karine Chiasson. Celle-ci étant une professionnelle de la danse percussive, notamment du gumboots, nous nous sommes dit que ça serait intéressant de mettre des capteurs sur des bottes et de voir comment on peut augmenter la performance percussive avec ceux-ci.

Lors de cette première phase de recherche réalisée à la Maison pour la danse de Québec, grâce au soutien de Première Ovation (volet arts numériques), j’ai réalisé un premier prototype de botte intégrant des capteurs de pression. Une scénographie robotisée permettait de faire pivoter des écrans de télévision ainsi qu’un dispositif son et lumière simple. Les explorations ont porté autour de l’interaction du performeur avec la lumière, le son, la projection vidéo et la scénographie robotisée, le tout à partir des capteurs sur les bottes.

J’ai aussi utilisé ce temps pour poursuivre la création et le développement de mon logiciel de traitement de capteurs dans Max. Mon but était d’en faire un outil plus flexible qui allait permettre de programmer des spectacles en enregistrant des cues de diverses assignations des différents capteurs vers les différents médias.

H+

En 2022, j’étais de retour avec le metteur en scène Émile Beauchemin pour son projet H+. Nous voulions capter en temps réel plusieurs données afin de les afficher sur un écran en arrière-scène, afin que le public puisse bien suivre le développement de son marathon :

- Rythme/fréquence cardiaque

- Vitesse de sa course

- Distance parcourue

- Nombre de pas effectués

- Approximatif des calories brulées

Pour le rythme cardiaque, j’ai utilisé les capteurs biométriques de la compagnie Movesens, en tandem avec l’application pour iPhone et Apple Watch Holon.ist, qui permet de transformer les données du capteur dans le protocole OSC et de les envoyer à la régie via WIFI pour que je puisse ensuite les traiter. Le logiciel Holon.ist m’envoie aussi les différentes données de la Apple Watch, notamment le nombre de pas parcourus.

Ce spectacle était aussi la première fois où mon logiciel de traitement de capteurs était utilisé lors d’une diffusion devant public. Le tout s’est passé assez bien.

C’est aussi pour ce projet que j’ai créé une tête de robot, mais celle-ci fera l’objet d’un autre article!

Contre corps

Nous voilà en 2023, alors que Karine Chiasson et moi tentons notre chance au CALQ et au CAC afin d’obtenir un nouveau financement pour notre projet, qui s’appelle maintenant Contre corps, et victoire! Notre projet est retenu au CAC dans le programme axé sur la recherche. Nous entamons donc une nouvelle phase exploratoire, où l’aspect technique se concentre sur l’objectif suivant : la création d’un costume fiable et performant, où les capteurs et les fils sont dissimulés et où les problèmes techniques potentiels sont réduits au minimum.

Pour cette nouvelle recherche, nous impliquons dans le projet l’interprète Valérie Pitre. Son important bagage, autant en danse contemporaine qu’en danse percussive, en fait une artiste parfaite pour ce projet. Karine agit à partir de ce moment en tant que chorégraphe.

Une première résidence en studio

Une première résidence de deux semaines a eu lieu à la Maison pour la danse, où nous avons décidé de concentrer nos efforts sur deux éléments :

- Le placement des capteurs sur le corps

- L’interaction avec la musique

C’est aussi lors de cette résidence que j’ai abandonné le développement de mon interface Max pour le traitement des capteurs. La raison? La découverte du logiciel Chataigne, dont la fonction est exactement la même : le traitement de données entre capteurs et médias numériques. La différence est que ce logiciel est activement développé, beaucoup plus performant et vaste dans ses possibilités. J’utilise toujours Max, mais pour des fonctions plus spécifiques.

Du travail dans mon fablab

Une nouvelle technologie que nous n’avions pas dans les autres projets est maintenant très accessible : l’impression 3D. Ayant personnellement acquis deux modèles d’imprimante 3D, une Prusa MK3 et une Snapmaker J1, j’ai passé plusieurs jours à explorer comment intégrer les capteurs dans un costume en utilisant cette technologie. Plusieurs tests et explorations ont été effectués :

- Impression sur tissus

- Intégration des capteurs et de l’électronique directement dans l’impression 3D

- Confection de pochettes en filament flexible

- Conception de boitiers pour l’électronique

Une deuxième résidence en studio

Une seconde résidence d’une semaine a servi à tester plusieurs éléments :

- Les solutions d’intégration technologique au costume développées dans mon studio grâce à l’impression 3D.

- L’utilisation de capteurs qui ne se trouvent pas sur le corps du performeur

- Capteurs de force sur des cordes

- Lidar

- Kinect

- L’intégration des capteurs au costume

- L’interactivité avec la lumière

- L’interactivité avec le son

- L’interactivité avec une simulation virtuelle de scénographie robotisée

Quelques derniers ajustements

Nous avons terminé cette phase de recherche par une dernière résidence dans mon studio, en testant les diverses idées que nous avions prises en note durant la deuxième résidence.

La suite

Comme vous pouvez le voir, c’est un projet très complexe et de longue haleine, mais on commence à avoir des résultats fiables et performants.